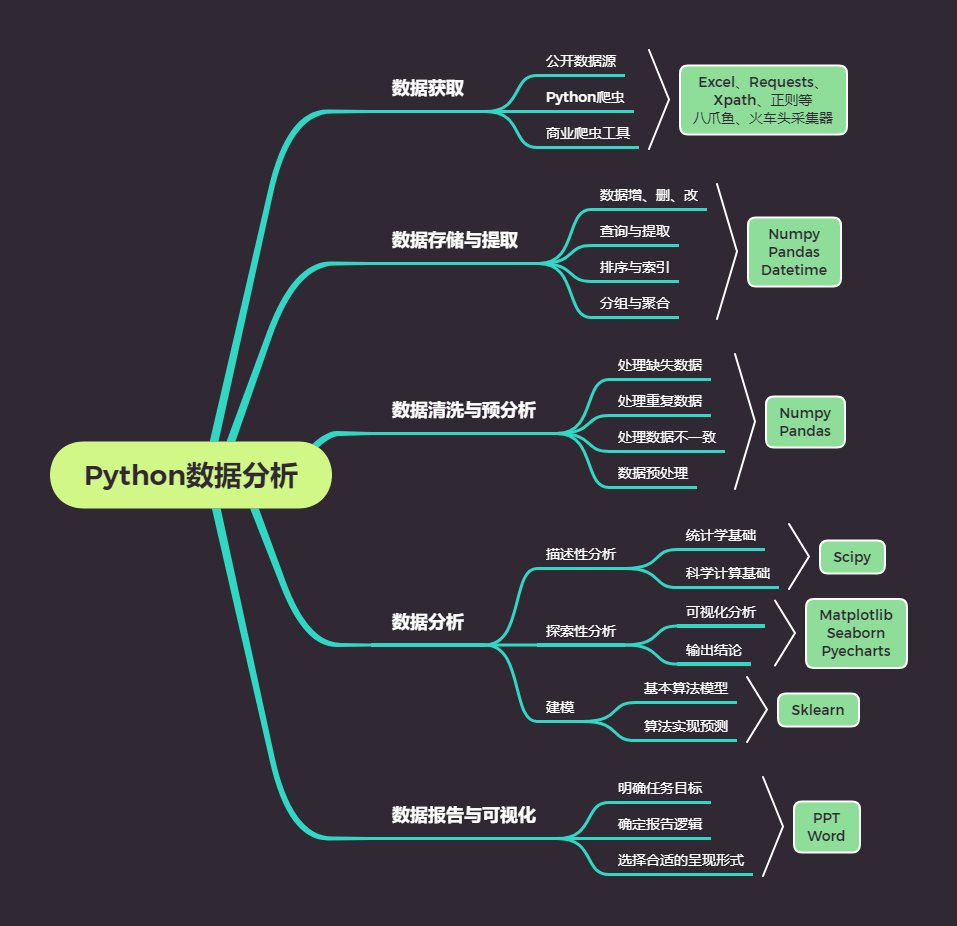

摘要:通过Python爬取网站数据并进行分类,可以实现对海量信息的快速获取和整理。具体过程包括利用Python的爬虫库如Requests、BeautifulSoup等获取网站数据,然后通过正则表达式、数据清洗等技术对数据进行预处理和筛选,最后根据数据的特征和属性进行分类存储和分析。这种方法广泛应用于数据挖掘、信息检索等领域,有助于提高数据处理效率和准确性。

本文目录导读:

随着互联网的发展,网站数据呈现出爆炸式增长,如何有效地获取、处理和分析这些数据,成为了一个重要的研究课题,Python作为一种强大的编程语言,广泛应用于数据科学、机器学习、Web开发等领域,其爬虫技术更是在网站数据获取方面发挥着举足轻重的作用,本文将介绍如何使用Python爬取网站数据,并对数据进行分类处理。

Python爬虫技术概述

Python爬虫是一种通过自动化脚本模拟浏览器行为,从网站上获取数据的技术,常用的Python爬虫框架有Scrapy、BeautifulSoup等,这些框架提供了丰富的API和方法,使得我们可以方便地实现网页数据的爬取、解析和存储。

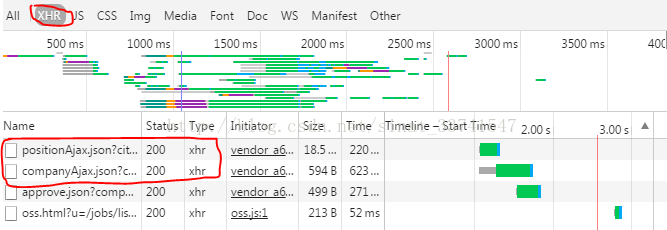

网站数据爬取步骤

1、发送网络请求

我们需要使用Python的requests库发送网络请求,获取网页的HTML代码。

import requests url = "http://www.example.com" response = requests.get(url) html = response.text

2、解析HTML代码

获取到网页的HTML代码后,我们需要使用爬虫框架提供的解析器对HTML代码进行解析,提取出我们需要的数据,以Scrapy框架为例,我们可以使用XPath或CSS选择器来定位数据。

3、存储数据

将解析得到的数据存储到本地或数据库中,以便后续处理,常用的数据存储方式有CSV、JSON、SQLite等。

数据分类处理

在获取到网站数据后,我们往往需要对数据进行分类处理,数据分类的方法有很多种,下面介绍两种常见的方法:

1、基于规则的分类

我们可以根据数据的某些特征,制定一系列规则对数据进行分类,如果我们要对新闻进行分类,可以根据新闻的标题、内容、关键词等特征,制定分类规则,将新闻分为政治、经济、社会、娱乐等类别。

2、基于机器学习的分类

对于复杂的数据分类问题,我们可以使用机器学习算法进行分类,我们需要准备足够的数据集,然后使用Python的机器学习库(如sklearn)进行模型训练,训练完成后,模型可以自动对新的数据进行分类。

实现示例

下面是一个简单的Python爬虫示例,演示如何爬取网站数据并进行基于规则的分类处理:

import requests

from bs4 import BeautifulSoup

发送网络请求,获取网页HTML代码

url = "http://www.example.com"

response = requests.get(url)

html = response.text

使用BeautifulSoup解析HTML代码,提取数据

soup = BeautifulSoup(html, "html.parser")

data_list = [] # 用于存储提取的数据

for item in soup.find_all("div", class_="item"): # 定位数据所在的HTML元素

title = item.find("h2").text # 提取标题

content = item.find("p").text # 提取内容

data_list.append({"title": title, "content": content}) # 将数据添加到列表中

基于规则的分类处理

def classify_data(data):

if "政治" in data["content"]: # 根据内容中的关键词进行分类

return "政治类"

elif "经济" in data["content"]:

return "经济类"

else:

return "其他类"

对数据进行分类处理并打印结果

for data in data_list:

print(classify_data(data)) # 输出数据的分类结果本文介绍了Python爬取网站数据的步骤和数据分类处理的方法,通过示例代码,我们了解了如何使用Python爬虫技术获取网站数据,并使用基于规则的分类方法对数据进行处理,在实际应用中,我们还可以结合机器学习方法进行更复杂的分类处理,随着人工智能技术的发展,自动化数据爬取和智能分类处理将成为未来的趋势,希望本文能对你有所启发,帮助你更好地应用Python爬虫技术处理网站数据。

京ICP备11000001号

京ICP备11000001号